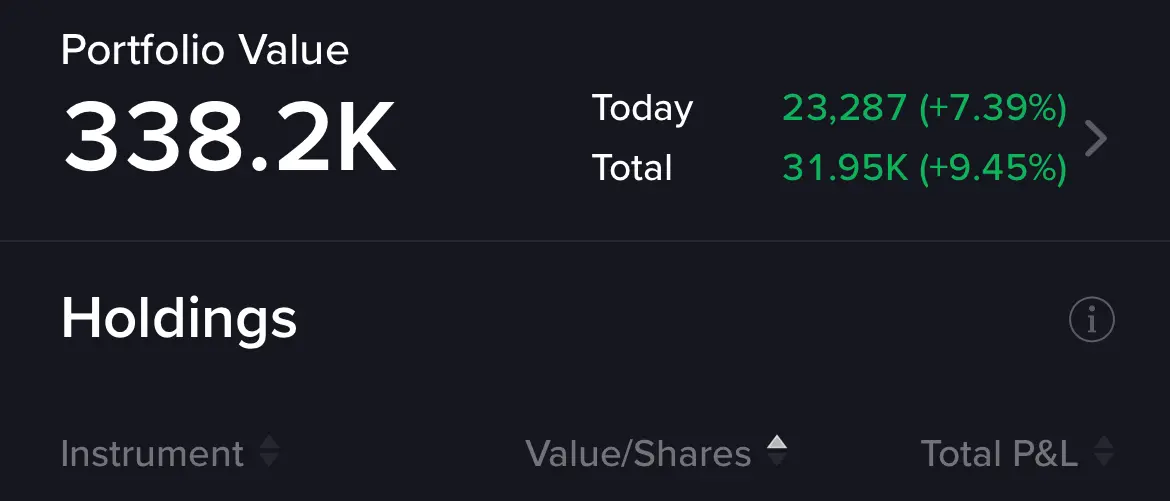

$TSLA 重上$488打氣區(44)

別了夏天

731 回覆

4 Like

1 Dislike

試下含撚

Camera贏晒

Tesla股東獲CRCL挖角

稱再多錢也無法離開馬斯克

喜歡在牛市環境艱難地投資

稱再多錢也無法離開馬斯克

喜歡在牛市環境艱難地投資

冇得救啦 股市都新高啦

伊朗我屌你老母

呢個星期真係極奇嘔心

係。Robotaxi 由0去1,已經做到。

之後1去100,100去10000就係時間問題

之後1去100,100去10000就係時間問題

俾少少時間

del 返兩個月app 再返黎唔洗俾人震走 輕鬆

del 返兩個月app 再返黎唔洗俾人震走 輕鬆

你係咪說服緊自己

Ching有啲似移英港人咁

只可以唱好

唱衰就5毛白卡

Ching有啲似移英港人咁

只可以唱好

唱衰就5毛白卡

Waymo 呢種做法完全係tight coupling

AI算法升級要考慮全部曬sensor lidar 同rador

AI算法升級要考慮全部曬sensor lidar 同rador

我咪話Waymo係競爭對手囉,有咩問題呀

關移英撚咩事,9唔L答8

關移英撚咩事,9唔L答8

真係好似

移加果啲鍾意屌就屌,移英果啲唔知係咪接受唔到自己做錯決定,要呃埋自己

移加果啲鍾意屌就屌,移英果啲唔知係咪接受唔到自己做錯決定,要呃埋自己

都唔知你up乜春,人地講緊Waymo,真係on L 7 9

https://www.facebook.com/share/p/1Zgt7xugRz/

自動駕駛廠商最愛吹噓sensor fusion,說什麼「360度全方位感知」「比人眼更精準」。聽起來很厲害,但關鍵問題是:要融合這麼多感測器的資料,系統負擔有多重?

你知道嗎?一台自動駕駛車每小時產生5.17TB資料,相當於1000部高畫質電影的容量。汽車的匯流排頻寬有限,光是處理這些資料就夠嗆了,更別說要即時做出生死攸關的決定。

問題有多嚴重?

#時間同步災難:相機通常以30 FPS拍攝,主流汽車LiDAR如Velodyne VLP-16雖然可達5-20 Hz,但常見設定為10 Hz。研究顯示,只有86.6%的感測器訊息能在50毫秒內同步,最長不同步期間可達850-880毫秒。即使10 Hz的LiDAR,也就是每100毫秒才更新一次3D環境資訊。

#即時處理挑戰:自動駕駛需要每8毫秒處理120 FPS的資訊,從最後一個像素輸出到感知結果只能花費幾毫秒。端到端延遲必須控制在50-100毫秒內,即使100毫秒的延遲都可能是生死攸關的差異。

#運算挑戰現實:L4級自動駕駛需要320 TOPS運算能力,L5級更需要4000+ TOPS。NVIDIA Drive PX Pegasus達到320 TOPS但功耗高達500瓦,Tesla FSD晶片能提供72 TOPS但只需40瓦以下。問題是,要整合多感測器資料進行即時決策,現有系統要嘛功耗過高,要嘛運算能力不足。

#惡劣天氣崩潰:在下雨、起霧時,不同感測器給出的資訊天差地遠,雷達會誤判金屬物體如路標或護欄,甚至無法區分動物屍體和路面。而根據中國的許多自動駕駛系統路測,很多原本光達宣稱擅長的路況,比如說濃霧,表現得比純攝影頭系統差,多感測器方案所謂的安全備援也就成了笑話。

現實很骨感

特斯拉的純視覺方案實際路測表現更好也說明,多感測器融合雖立意良好,但絕對不是目前系統性能與頻寬受限狀況下的最佳解。

你都係移英唔好扮唔知

每日都高開低收嘅垃圾 阿婆都識玩

你睇下上面IBM巴打篇篇學下野啦

唔係喎,智商80以下嘅人睇唔明架喇

唔係喎,智商80以下嘅人睇唔明架喇

甘L得得研究移英移加撚,做下實事,花d時間了解下FSD好L過啦

點解我要研究

好L有米,係我錯

我作為一個窮L, 你叻