依家d人電腦知識真係少到可怕,仲要自信爆棚

點解Deepseek 成本咁平?

https://lih.kg/3864830

- 分享自 LIHKG 討論區

TLDR: deepshit 皮 gpt底

真係落手由零開始開發嘅美國唔知燒左幾多十億鎂先出到隻GPT3 造福人類

屌你俾幾十萬人仔個商業間諜成個model拎走

一般人唔識好正常依家已經用緊llm寫code同埋troubleshoot linux甚至mikrotik routeros既問題

就算it人,我覺得llm野追黎冇咩用

d野下個月就out

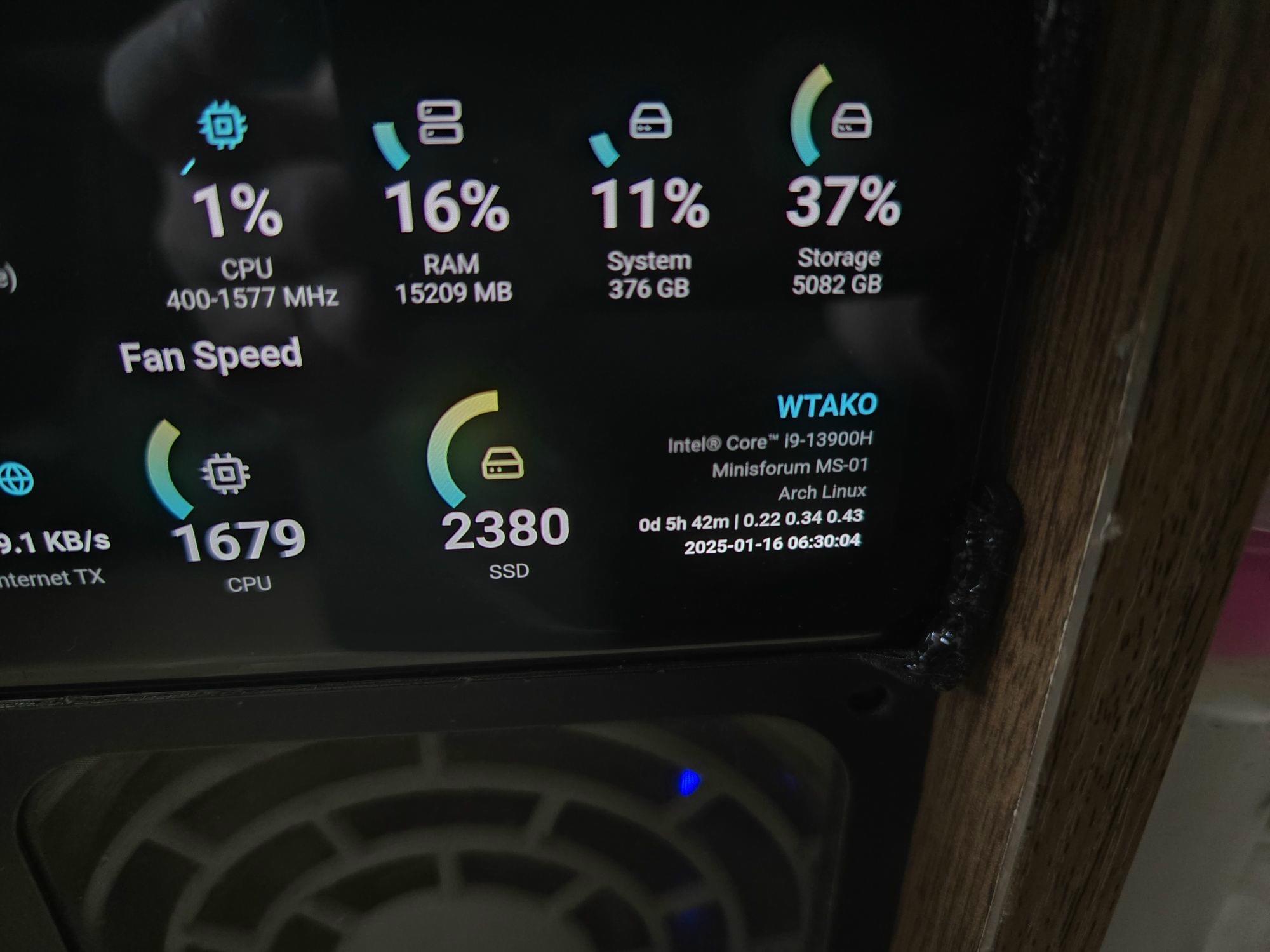

前排幾個鐘寫左個system monitor既Frontend同backend

追黎有冇用見仁見智